OpenAI 的「群聊」,可能比你想得更重要!

OpenAI 的「群聊」,可能比你想得更重要!协作 AI,可能是 AI 助手的下一步?

协作 AI,可能是 AI 助手的下一步?

“What is meant often goes far beyond what is said, and that is what makes conversation possible.” ——H. P. Grice

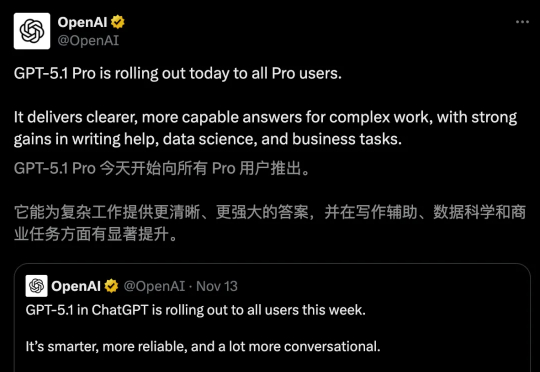

AI圈一日一更的频率,真的是有点跟不住了....前两天,先是Grok 4.1、Gemini 3 Pro发布,今天OpenAI GPT-5.1 Pro也静默登场了! 众所周知,GPT-5.1主打「情商智商」双强,Pro无疑将这两大优势推向更高层次。

在我们探讨今日关于Gemini 的新闻之前,需要提及今晨微软与英伟达宣布,将投资 Anthropic。该公司承诺在未明确时限内投入至少 300 亿美元租赁微软 Azure 云平台上配备英伟达芯片的服务器。至此,三大云服务商均已注资这家 OpenAI 的竞品,再次释放微软已从 ChatGPT 制造商分散投资的信号。

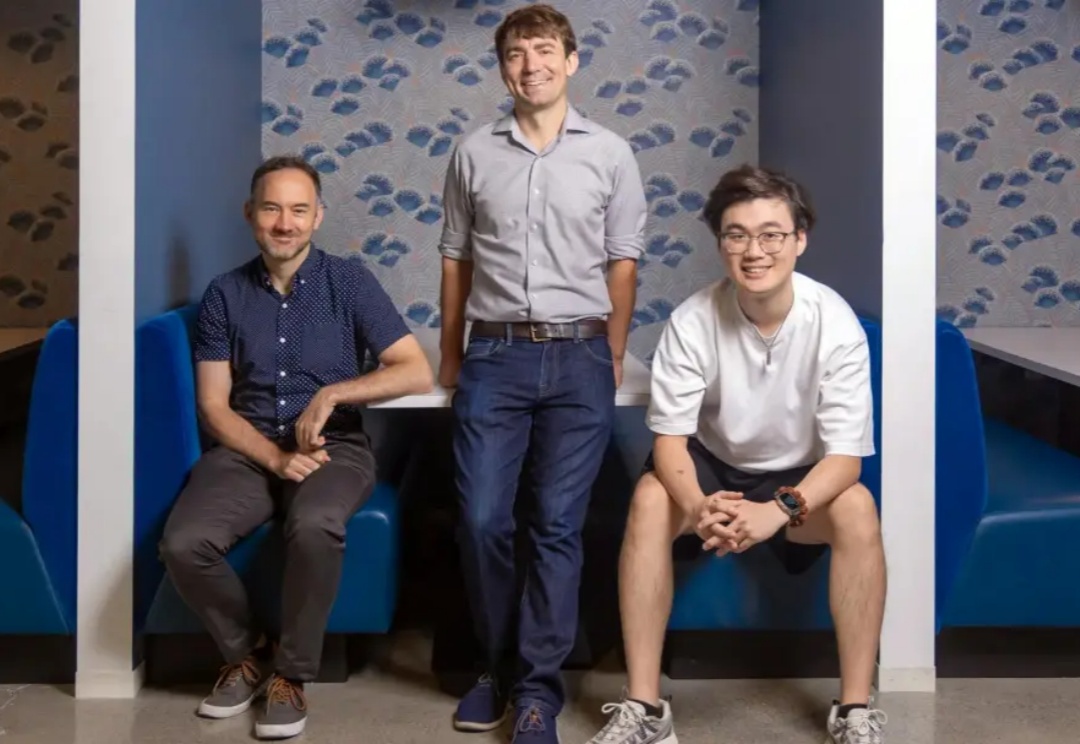

上个月 OpenAI 在发布 Sora 2 的同时将其作为独立应用发布,产品一经上线便登顶苹果应用商店榜首的现象级产品。本篇内容是对 Sora 2 的三位核心负责人的访谈:研发负责人 Bill Peebles、产品负责人 Rohan Sahai 以及工程与产品负责人 Thomas Dimson,Dimson 还参与过 Instagram 产品的搭建。

当美国巨头如Google、OpenAI 和 Anthropic 竞相开发支撑其 AI 产品的大型语言模型时,Sakana AI、Mistral AI、DeepSeek 和 AI21 Labs 等初创公司正凭借为特定地区、行业或独特功能设计的专业模型开辟自己的细分市场。

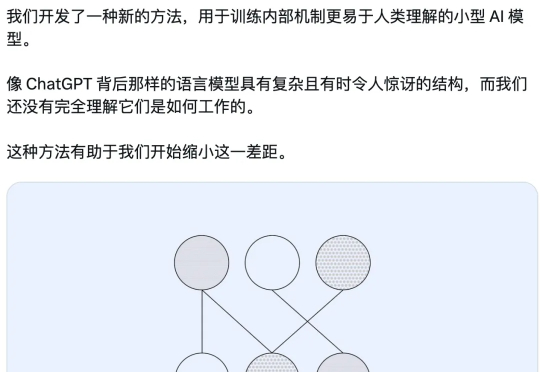

就在今天,OpenAI 发布了一项新研究,使用新方法来训练内部机制更易于解释的小型稀疏模型,其神经元之间的连接更少、更简单,从而观察它们的计算过程是否更容易被人理解。

最近,OpenAI 宣布:Sora 2 进一步开放使用权限,不再需要邀请码。

上周 Kimi K2 Thinking 发布,开源模型打败 OpenAI 和 Anthropic,让它社交媒体卷起不小的声浪,网友们都在说它厉害,我们也实测了一波,在智能体、代码和写作能力上确实进步明

近日,OpenAI 就公司财务状况发表公开声明而引发混乱后,面临不诚实的指控。而三天前,他的首席财务官提议政府应该“支持”该公司的基础设施贷款。她后来声称说错了话。OpenAI 首席执行官 Sam Altman 在三天前,他的首席财务官提议政府应该“支持”该公司的基础设施贷款。她后来声称说错了话。